1.通用解决方案

原因分析:

1,在安装ollama服务的本机运行

2,在其他机器访问安装ollama的机器

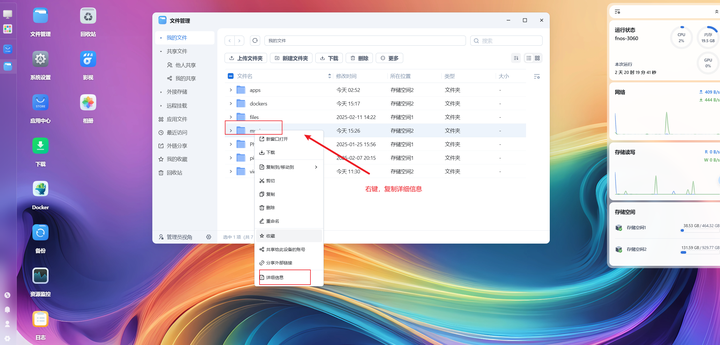

检查系统配置:不是的,改为一致的

变量名:OLLAMA_HOST

变量值:0.0.0.0

变量名:OLLAMA_ORIGINS

变量值:*

2. Linux解决方案

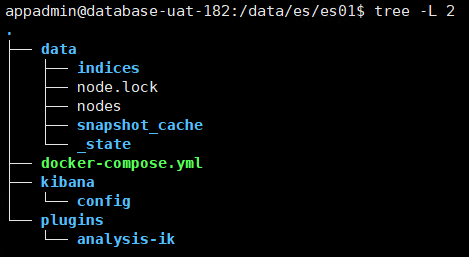

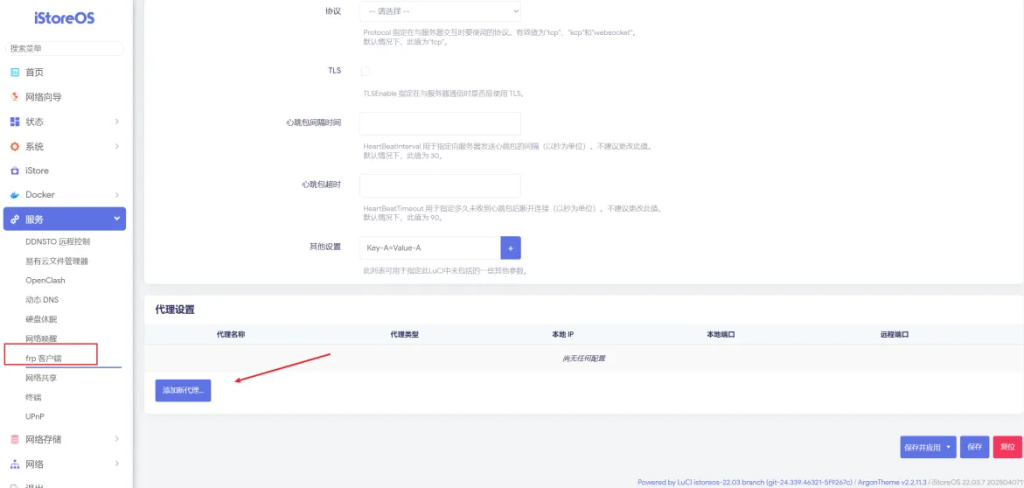

如果你是在Linux上使用Docker部署的,可以参考如下方案:

修改文件:

vim /etc/systemd/system/ollama.service增加跨域配置:”OLLAMA_ORIGINS=*”

[Unit]

Description=Ollama Service

After=network-online.target

[Service]

ExecStart=/usr/local/bin/ollama serve

User=ollama

Group=ollama

Restart=always

RestartSec=3

Environment="PATH=/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin:/usr/local/jdk-8/bin" "OLLAMA_HOST=0.0.0.0:11434" "OLLAMA_ORIGINS=*"

[Install]

WantedBy=default.target

AcJava,让技术学习更简单!

我是铭轩,微信:ac_java,欢迎与我随时交流!

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END

暂无评论内容